最近,在各大社交平台上,一款叫作“盗梦师”的AI绘画小程序火了。

具体火到什么程度呢?据以往团队的采访得知,9月产品刚上线一周时间,盗梦师便创造了日增5万用户的纪录。

从Midjourney 到 Stable Diffusion,再到国内如雨后春笋般涌现的AI绘画平台,在使用方式上差异不大,均采用「以文生图」的方式。「以文生图」顾名思义就是只要你把想法、脑洞以文字输入给AI,这些文字描述就会被算法驱动,变成一张张生动、精致的图片。

而真正能让盗梦师从众多AI绘画平台中脱颖而出的,当属其鲜明的技术优势与舒适的产品体验。

从输入描述到输出图片,全程仅不到5秒,对比其他产品动辄几十秒甚至几分钟的时间,可谓天壤之别。

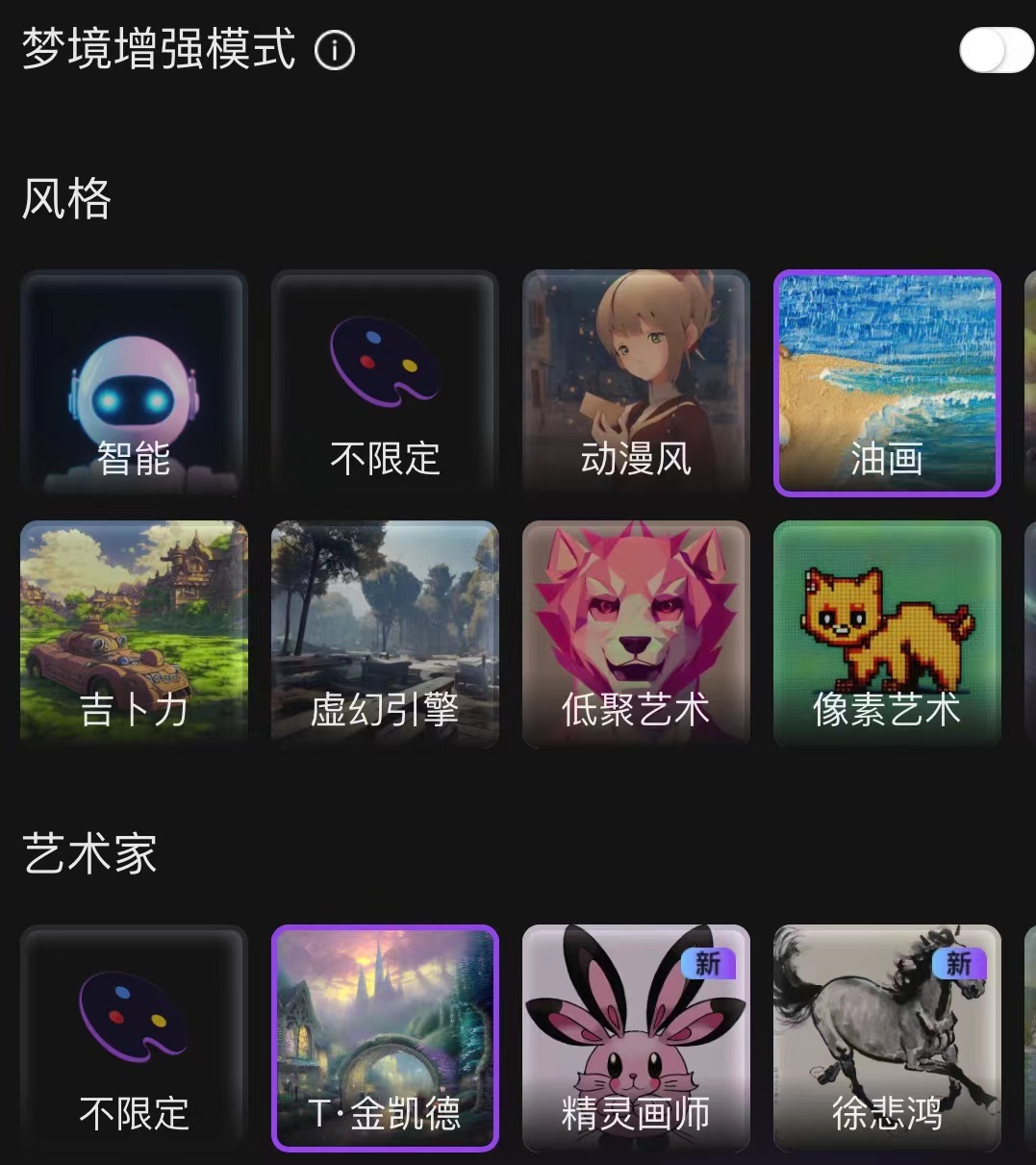

同时还有多种绘画风格、多图批量输出、多尺寸高分辨率、画师参考等功能辅助用户开展创作,使得整个绘画过程更便捷、有趣和惠普。加之其免费的新手体验,上线以来便在用户间产生了良好的口碑。

据了解,盗梦师由前谷歌人工智能研究院科学家、NLP自然语言处理领域预训练语言模型“ALBERT”第一作者——蓝振忠博士带队研发。

最终由西湖大学深度学习实验室和西湖心辰科技有限公司(西湖大学深度学习实验室孵化的 AIGC 创业公司)共同推出。

依托于西湖大学良好的科研和成果转化环境、充足的科研资金及软硬件设备,西湖心辰组建了一支长期致力于研究自然语言处理,计算机视觉及深度学习的结合与应用的团队。

在Stable Diffusion的基础上,盗梦师凭借团队在AI领域多年的深耕以及西湖大学实验室的成熟算力,找到了一个可发挥自有技术优势的地带,并通过“秒生图,生精图”的特点快速占领AI画画高地。

我们通过原生stable diffusion在pytorch、TensorRT与Oneflow三个框架下的实现与盗梦师自有模型对比可以看到:

pytorch上原生的Stable diffusion生成一张图需要3.4s,第三方Oneflow需要1.4s生成时间。而盗梦师的自有模型只需要0.8s,并且不会影响生成效果。

这是因为盗梦师针对速度和质量两个方面分别做了技术优化,在提速侧,进行了算子重写、模型量化、采样函数优化;在提质侧,采用了自有中文语言模型、多尺寸弹性训练等。这才使得盗梦师在生成图片时,不仅速度上有了质的提升,最终的呈现效果也有明显优化。

从今年8月发布至今,Stable Diffusion仍是最火的开源AI生图模型。与其他开源图片生成模型相比,其有着出图速度快、质量高等特点。

但在画人物方面,Stable Diffusion的弊端也很明显,如经常存在多头、多只手、多条腿或人物部分肢体丢失等问题。

原生 Stable -Diffusion(左)与盗梦师(右)对比

同时,原生Stable Diffusion仅支持英文作为唯一输入语言,对于国内用户来说也十分不友好。

针对语言障碍的问题,国内曾有团队开源了支持中文的stable diffusion 模型——“太乙 Stable Diffusion”。但经测试发现,太乙Stable Diffusion虽然能够理解中文独特的文化表达,但语义理解方面仍有所欠缺,会给出与输入prompt不匹配的图片。

如输入:雾气弥漫的森林,中世纪风格霍比特人村庄

太乙 Stable Diffusion(左)与盗梦师(右)对比

而且无论对于哪种模型,图片质量的好坏都与输入的关键词密切相关,专业、适当的输入词需要用户有大量的经验,新手往往用户难以克服。

因此,改变模型是一切问题的根本解。

如上文所说,文生图效果由模型的图像生成能力与自然语言理解能力共同决定。于是,盗梦师团队在训练图像生成能力的同时着重加强了机器理解层的能力,使自己区别于市面上的其他平台。

在图像生成方面,盗梦师根据过往在AI生成领域积累的经验,在前期做了大量科研和训练工作。并且使用了与Stable Diffusion不同的训练方案,使得盗梦师生成的图片更加精细,不会产生截断等问题。

在语义理解方面,依赖于西湖心辰在NLP领域的大量技术与数据积累,盗梦师自有模型不仅能更好地理解用户输入词,还扩大了原生Stable Diffusion的文本长度限制,支持更长的文本输入。

此外,针对不懂得如何撰写关键词的新用户,盗梦师还开发了“梦境增强模式”,可以对用户的输入词做联想增强,帮助新手画师更轻易地画出惊艳的图片。

当然,盗梦师目前仍然存在一些业内普遍的待解决的问题,比如众所周知的AI画手、AI吃面画的缺陷

在蓝振忠看来,目前AI绘画仍处于早期阶段,虽然目前的图片生成 AI 能力确实到达了历史上的峰值,但还是需要更大的规模的数据以及更长时间的训练。

持续迭代后的AI,绘画速度会更快,可以及时调控的能力也会更强。以盗梦师自我进修的速度和深度来看,我们有理由相信它将是未来引领 AIGC 潮流的先锋。

文|柿厂