1、AI数据中心需求激增,AI服务器快速放量

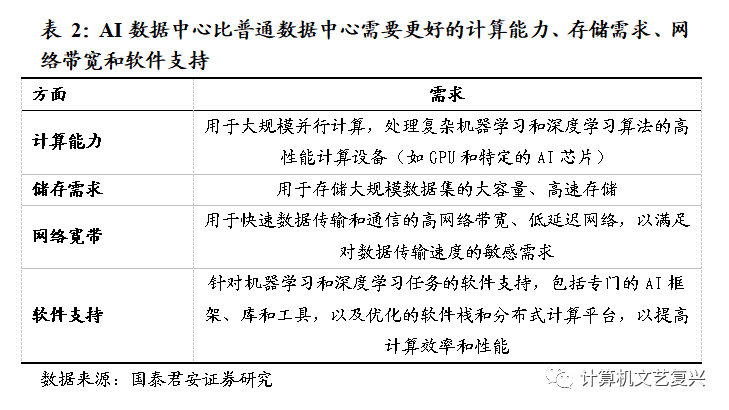

AI数据中心是专门用于支持人工智能计算和数据处理任务的设施或物理空间。它在传统数据中心的基础上进行了特殊配置和优化,以满足机器学习、深度学习和其他AI相关任务的需求。AI数据中心通常拥有大量高性能的服务器、GPU加速器和专门的存储系统,以提供强大的计算能力并加速深度学习。此外,AI数据中心还配备了高速的网络设备和优化的软件框架,以支持高效的数据传输和算法训练。通过这些专门的配置和优化,AI数据中心能够为各种规模和复杂度的AI工作负载提供可靠稳定的计算环境,并满足大规模数据存储、备份和分析的需求。AI数据中心在推动人工智能技术的发展和应用方面起到关键作用,为各行各业的AI应用和服务提供了强大的支持。

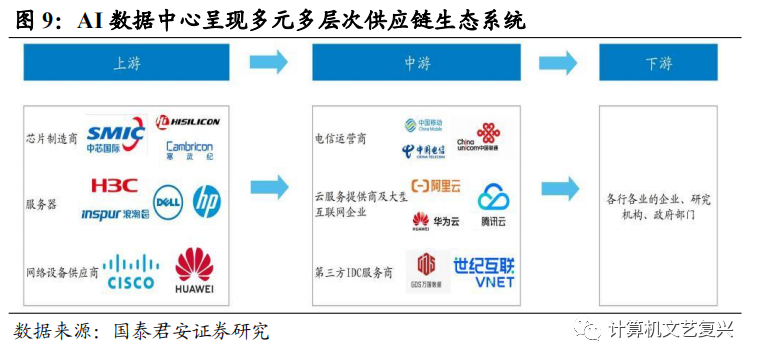

AI数据中心的行业格局呈现出多层次的供应链结构,包括上游的数据中心设备制造商和解决方案供应商,中游的云服务提供商和大型科技公司,以及下游的企业用户和个人开发者。这些不同环节的参与者相互合作,共同构建了一个竞争激烈且多元化的生态系统。

AI数据中心上游主要有芯片制造商、服务器和网络设备供应商等。芯片制造商包括如海思、寒武纪、中芯国际等等,在AI数据中心中提供高性能的芯片解决方案。在服务器领域,国内的浪潮、新华三等企业以及国际企业如戴尔、惠普等都在中国市场有一定份额。网络设备方面,华为、思科等公司提供了关键的网络基础设施。

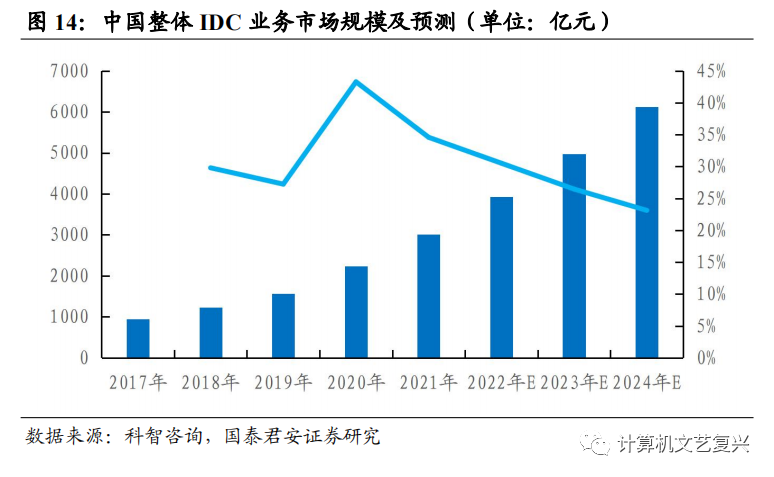

AI数据中心中游主要有电信运营商、云服务提供商及大型互联网企业和第三方IDC服务商。当前许多从事AI研发的互联网企业,像亚马逊、百度、腾讯等都已部署自己的AI数据中心。阿里云、腾讯云和华为云等大型云服务提供商开始提供云计算、存储、AI平台等服务。它们利用自身的技术和资源为企业和研究机构提供AI解决方案和支持。电信运营商方面,中国电信、中国移动、中国联通等传统电信运营商在建设数据中心基础设施方面投入大量资源并提供AI相关服务。第三方IDC服务商比如万国数据、世纪互联等也在AI数据中心市场中扮演重要角色。它们提供数据中心托管、云主机、网络带宽等服务,满足企业和机构对AI数据中心基础设施和运维的需求。这些服务商通常提供灵活的解决方案,使企业能够快速部署和扩展AI应用。

AI数据中心的下游用户需求主要来自各行各业的企业、研究机构和政府部门。这些用户根据自身需求选择合适的云服务提供商或搭建私有数据中心,以满足其对AI技术的需求。下游用户需求的多样性使得AI数据中心市场分散。

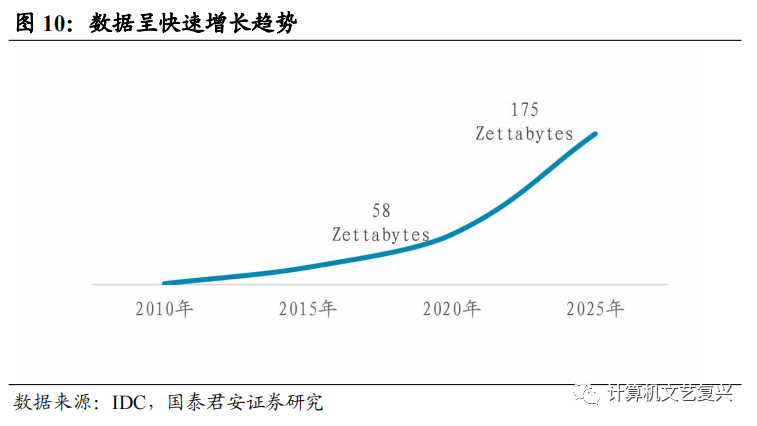

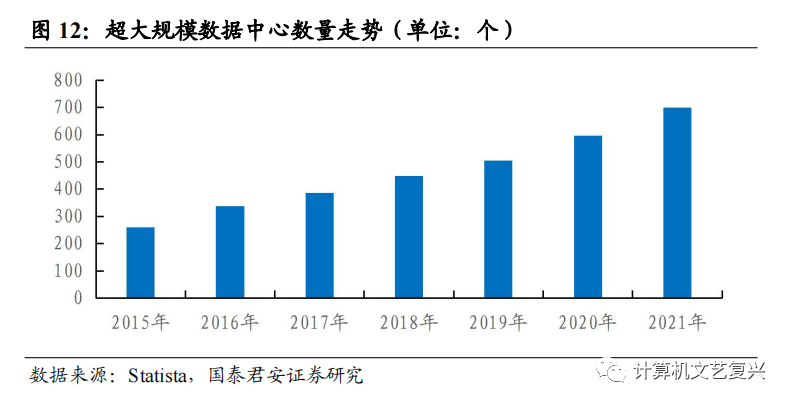

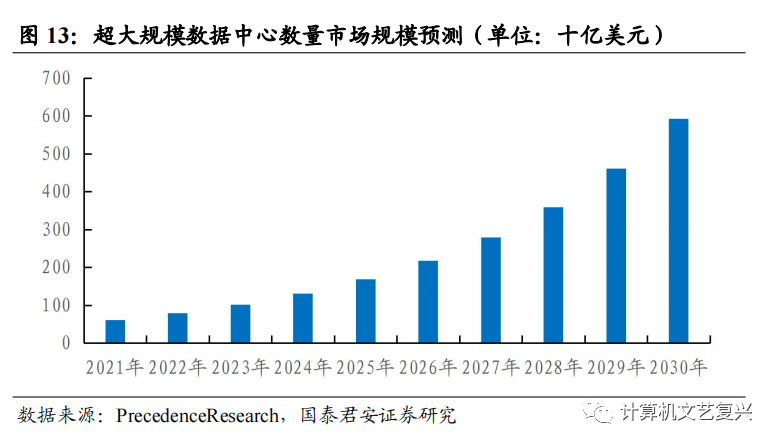

随着AI行业应用继续深入发展,AI数据中心的数量和规模将会持续增加。这一趋势受到数据量增加和应用需求的推动、ChatGPT带来的算力增量需求以及技术创新的支持。AI数据中心作为支持大规模数据处理、深度学习模型训练和推理的关键设施,将发挥重要作用,推动人工智能技术的广泛应用和进一步的创新。

数据量的增加和AI应用的扩展是AI数据中心发展的重要驱动因素。随着物联网、社交媒体和传感器技术等数据源的增多,AI数据中心需要处理和存储更大规模的数据集。根据IDC报告,在2014-2020年,平均每个IT人员管理的数据量从230GB增加到1231GB,超过5倍。而企业数据则预计将以42.2%的速度增长。同时,人工智能技术在各行各业的广泛应用以及对深度学习模型的训练需求也促使了对AI数据中心的需求增加。

大模型的出现带来了算力的增量需求。根据OpenAI发布的有关GPT-3模型的文档,它包含1750亿个参数,需要进行数千万次的计算操作来完成一次推理任务。ChatGPT的总算力消耗约为3640PF-days,需要7~8个投资规模30亿、单体算力500P的数据中心才能支撑运行,这样的规模和复杂性需要高性能的计算设备和大规模的并行计算能力,带动了AI数据中心需求的增长。

技术创新也对AI数据中心的发展起到推动作用。新的处理器架构、高速网络、存储技术以及更高效的冷却和能源管理系统的出现,提升了数据中心的性能和效率,为AI数据中心的发展提供了技术支持。

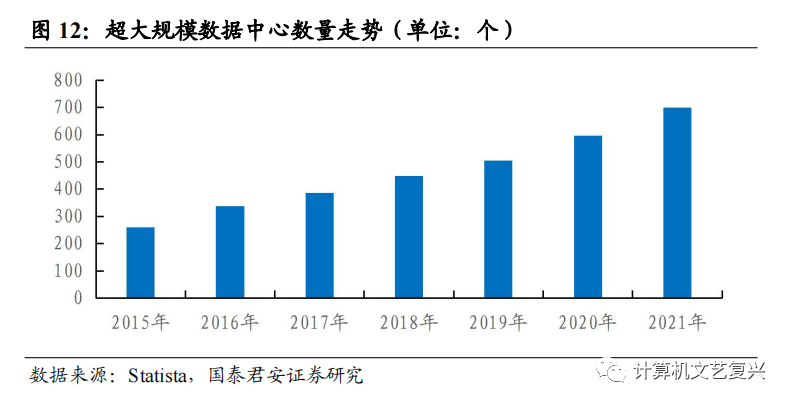

由于数据量增长、计算能力要求、技术基础设施需求和经济效益等共同驱动因素,预计专业的AI数据中心增长趋势与大规模数据中心增长趋势相同,未来几年AI数据中心呈现直线上升趋势。

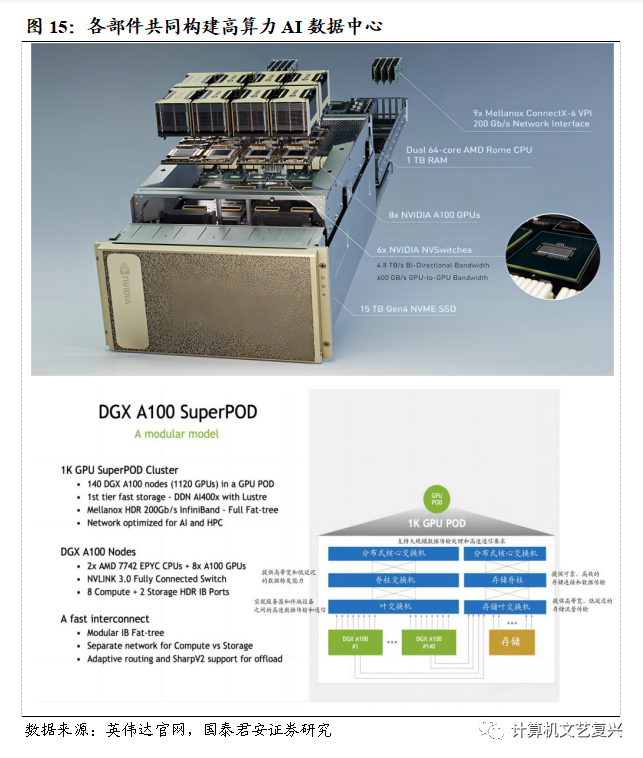

AI数据中心主要包括服务器、存储设备、网络设备、冷却系统以及电源设备等部分。这些组成部分共同构成了一个高效、可靠的基础设施,为数据中心提供了强大的计算能力和存储能力,支持AI算法的运行和数据的处理。

服务器是数据中心的核心,用于执行复杂的计算任务和运行人工智能算法。数据中心的算力大小取决于服务器的规模和数量,较大规模的服务器意味着更多的处理单元和计算资源,从而提供更强大的计算能力。

存储设备在AI数据中心中起着重要的作用,用于存储和管理大量的数据集和模型。这些存储设备包括硬盘阵列(RAID)、网络附加存储(NAS)等,它们为数据的存储和访问提供支持。存储设备的容量和性能决定了数据中心能够处理和存储的数据规模。更大容量和更高速的存储设备可以支持更多数据的存储和访问,从而为算力的发挥提供了必要的支持。

网络设备在数据中心中起到连接和传输数据的关键作用。AI数据中心需要高速、可靠的网络设备来连接服务器和存储设备以实现数据的快速传输,以及数据中心内部各个组件之间的高效通信。快速的数据传输和高效的通信能够提升算力的利用效率和数据处理的速度。

由于大量的服务器和计算设备会产生大量的热量,数据中心需要强大的冷却系统来保持设备的正常运行温度。冷却系统确保数据中心的温度适宜,防止设备过热而影响性能和可靠性。高效的冷却系统可以确保数据中心的稳定运行,保障算力的持续发挥。

电源设备是数据中心的基础设施之一,提供稳定的电力供应,保障数据中心稳定运行。发电机、UPS(不间断电源系统)和电力配电系统等电源设备提供持续稳定的电力供应,确保数据中心不会因为电力问题而中断运行,保障算力的连续可用性。

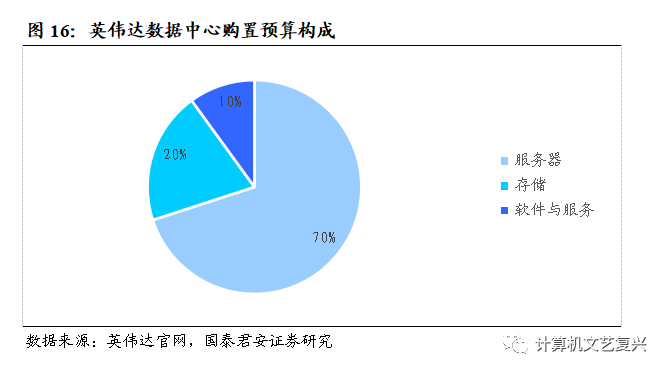

在AI数据中心中,服务器、存储设备、网络设备、冷却系统和电源设备的价值量占比会根据数据中心的规模、需求和架构设计等因素而有所不同。一般服务器占据较大的比例,服务器是AI数据中心的核心部分,用于执行复杂的数据处理和机器学习任务,根据中国信息通信研究院的研究数据,其价值量约占总体的70%左右。存储设备在AI数据中心中起到关键的作用,用于存储大规模的数据集、训练数据和模型参数,约占总体的15%至30%。根据前瞻研究院的数据显示,网络设备提供高速、可靠的数据传输和连接,其比例较低,约占总体的15%至20%,但仍然是不可或缺的部分。冷却系统和电源设备的比例相对较低,分别占总体的5%至15%,但它们对数据中心的可靠性和稳定运行至关重要。具体价值量占比因需求、行业差异和技术等因素有所不同。

2、AI服务器中,GPU价值量最大

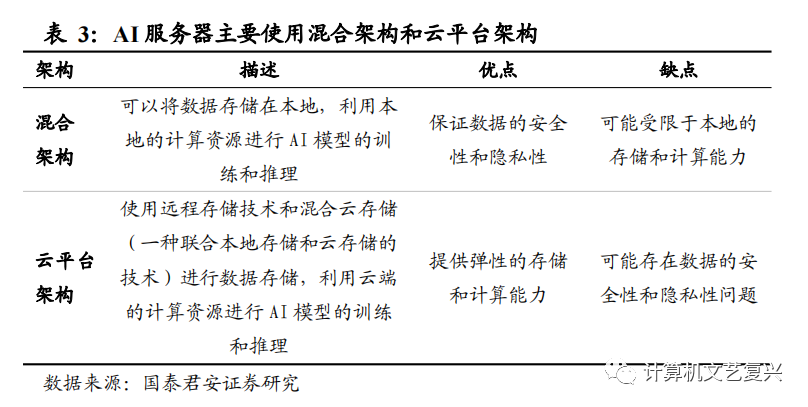

AI服务器是AI数据中心重要的组成部分。AI服务器是专门为人工智能应用而设计和配置的服务器,具备强大的计算能力和高效的数据处理能力,是执行AI任务和处理大规模数据的关键组件,为数据中心提供计算资源和算力,用于执行复杂的AI算法和模型。AI服务器有两种主要架构:混合架构和基于云平台的架构。混合架构允许数据存储在本地,而基于云平台的架构利用远程存储技术和混合云存储来进行数据存储,即联合使用本地存储和云存储技术。AI服务器通常采用异构架构,结合不同类型的处理器,例如CPU和加速卡(如GPU、TPU等),以提供更高的计算性能。这种异构架构使得服务器能够同时处理并行计算和特定的AI计算任务,加速数据处理和模型训练过程。作为数据中心的核心设备,AI服务器承载着计算、存储和网络功能,为数据中心的运行提供稳定的支持,以满足模型训练、推理和数据处理等任务的需求。其可扩展性使其能够适应不断增长的计算和存储需求,保持数据中心的性能和效率。

计算性能是衡量AI服务器性能的关键指标。它取决于处理器的性能和数量。对于AI任务,通常使用具有高度并行计算能力的处理器,例如中央处理器(CPU)、图形处理器(GPU)和张量处理器(TPU)。其中,浮点运算性能(FLOPS)、GPU核心数和频率、内存带宽、存储系统性能、网络性能和延迟会对AI服务器的计算能力产生影响。浮点运算性能衡量服务器处理深度学习任务的能力,GPU核心数和频率决定了并行计算的速度,更多的核心和更高的频率可以提供更快的计算速度和更高的并行处理能力,从而加速AI算法和模型的执行。内存带宽和存储系统性能影响数据读写效率,网络性能关乎服务器间数据传输,而延迟则与实时响应需求有关。这些指标综合考虑可以评估AI服务器的计算性能,选择和权衡取决于具体应用场景和需求。

AI应用需要处理大规模的数据集和模型,因此存储容量和速度也是AI服务器的重要属性。AI服务器需要提供足够的存储容量来存储数据和模型参数。同时,存储设备的读写速度也是至关重要的,它会影响数据的存取效率和模型训练的速度。传统的硬盘驱动器(HDD)可以提供较大的存储容量,而固态硬盘(SSD)则具有更快的读写速度和更低的访问延迟,对于快速的数据存取和模型加载至关重要。

更大的内存容量和更快的内存带宽可以支持AI服务器的高效数据处理和计算。内存容量和内存模块(RAM)会影响数据存储和传输能力。内存控制器的性能和总线架构决定了内存的带宽和效率。内存通道数量和频率也会影响内存的带宽和响应速度。此外,使用ECC(Error-Correcting Code)内存可以提高数据完整性和服务器可靠性。

AI服务器需要具备高速稳定的网络连接,以便与其他服务器、客户端和外部数据源进行通信和数据传输。AI服务器的网络连接速度受到多个部件性能的影响。网络接口卡(NIC)决定了服务器与网络之间的物理连接和数据传输速率。不同网络连接介质(如以太网电缆或光纤)具有不同的传输能力和带宽,影响服务器的连接速度。网络交换机和路由器的性能对数据包的路由和转发起着关键作用,它们的处理能力和转发能力会直接影响服务器的网络连接速度。网络协议和协议栈的优化以及网络拓扑和带宽管理策略也会对服务器的网络连接速度产生影响。

为了确保服务器的稳定性和可靠性,AI服务器需要有效的散热和冷却系统。散热器、风扇和冷却技术的效率决定了服务器在高负载条件下的散热能力。良好的散热和冷却设计可以降低温度,提高系统性能和可靠性。

AI服务器的高电源能效可以提供更好的性能功耗比,降低能源消耗和运行成本。电源单元通过稳定的电压输出和高效的电能转换提供稳定可靠的电源供应,并减少能量损耗。电源管理模块控制和监测电源的运行状态,提供精确的电源调节和能量管理,以优化服务器的能效性能。

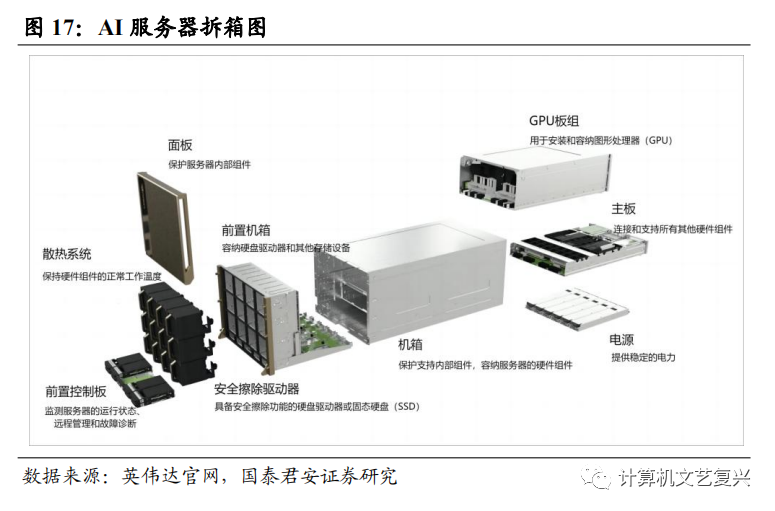

AI服务器中的主要元器件包括CPU、GPU板组、内存、存储、网络接口卡、机箱、主板、散热系统和电源。CPU负责执行计算任务和处理数据,是服务器的主要计算引擎,可以进行复杂的算法和模型运算。加速卡(如GPU、TPU)提供高性能的并行计算能力,用于加速机器学习和深度学习任务,可以加快模型训练和推理的速度。内存(RAM)用于临时存储数据和程序代码,提供快速的数据访问和处理能力。AI服务器通常配备大容量的内存,以支持大规模的数据集和模型。存储设备用于持久化存储数据和模型,包括硬盘驱动器(HDD)、固态硬盘(SSD)和存储阵列(RAID)等,提供高速的数据读写能力和大容量的存储空间。网络接口卡(NIC)提供高速稳定的网络连接,以便与其他服务器、客户端和外部数据源进行数据传输。机箱是AI服务器的外部框架,提供支撑和保护内部组件的结构。背板提供连接各个部件的接口,而布线则用于传输电力和数据信号。主板是AI服务器的核心电路板,连接各个部件并提供电源和数据传输的接口,承载着CPU、内存插槽、扩展插槽和其他重要组件。散热系统用于控制服务器的温度并保持其在安全范围内运行。散热片吸收和分散热量,而风扇则提供气流来冷却服务器内部。电源提供服务器所需的电能,确保各个组件正常运行。

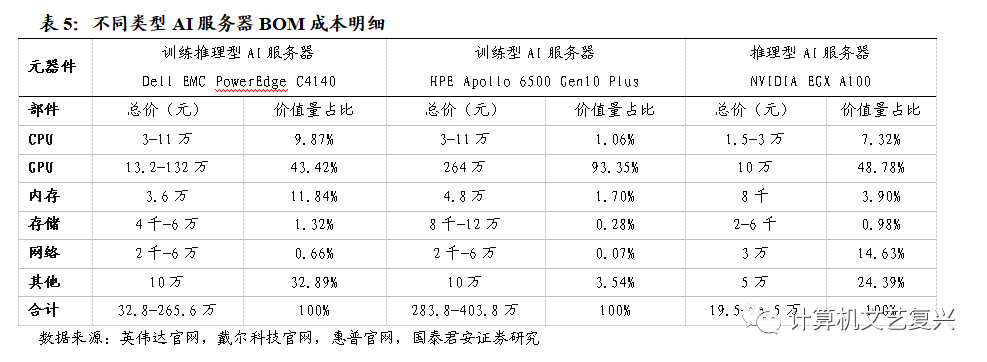

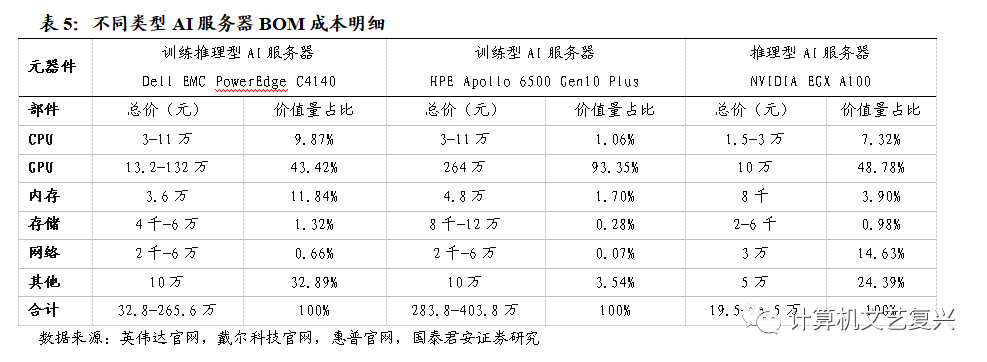

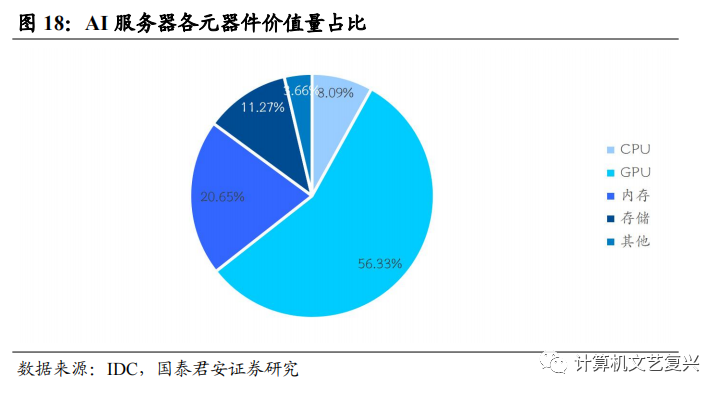

在训练型AI服务器中,通常CPU价值量占比9.8%,GPU占比72.8%,内存占比8.7%,其他占比8.7%。推理型AI服务器中,CPU价值量占比10%,GPU占比50%,内存占比10%,存储占比5%,其他占比25%。以英伟达训练、推理和分析通用的高性能 AI 系统Nvidia DGX H100 为例进行成本拆分,GPU价值量占比则更高,占比86.66%。而CPU价值量则占比2.31%,内存占比3.49%,存储占比1.54%,网络接口卡占比4.85%,其他占比1.15%。

AI服务器的组装和集成价值量取决于多个因素,包括服务器的型号、规模和配置等。组装集成价值量可以根据组装过程中所需的时间、人力成本以及技术要求来衡量。通常情况下,组装集成价值量相对于整个服务器的总成本而言较小,通常在几个百分比以内,具体数值可能会因不同的服务器和供应商而有所差异。对于高端的AI服务器,组装集成成本相对较高,因为它们通常具有复杂的硬件配置和特殊的要求。以英伟达的Nvidia DGX H100为例,服务器的组装成本为1,485美元,占整个服务器的0.553%。在整个AI服务器的总成本中,组装集成过程所占的比例相对较小。组装集成过程对于确保服务器的正常运行和性能发挥非常重要。精确的组装集成可以确保各个元件正确安装、连接和配置,从而保证服务器的稳定性和可靠性。虽然组装集成价值量相对较小,但它对服务器的整体性能和可用性具有重要影响。

在一个AI数据中心中,最重要的部件通常是服务器。服务器是执行AI计算任务、存储和处理大量数据的核心设备,为支持AI应用和服务提供高性能的处理能力、存储容量和网络连接。在一些大型AI数据中心中,服务器的投入比例通常在整体投入的60%至70%之间,占据较大的比例。